引言

在人工智能(AI)领域,规模定律(Scaling Law)是一个备受关注的话题。近日,英伟达(NVIDIA)的CEO黄仁勋在GTC(GPU Technology Conference)主题演讲中,提出了关于“Scaling Law”的独特见解,引发了广泛讨论。黄仁勋认为,全世界对Scaling Law存在误解,而深入理解这一规律,将有助于推动AI技术的进步和应用的拓展。

突破性观点:全世界都误解了Scaling Law

什么是Scaling Law?

规模定律是指,随着数据量和计算资源的增加,AI模型的性能会呈现出显著的提升。然而,黄仁勋指出,许多人对Scaling Law存在误解。他们往往过于依赖数据量和计算资源的增加,而忽视了其他关键因素,如算法优化和数据质量。

误解的根源

黄仁勋认为,误解的根源在于对Scaling Law的片面理解。许多研究者和企业在追求AI模型的性能提升时,往往将重点放在增加数据量和计算资源上,而忽视了算法的优化和数据的质量。实际上,算法的创新和数据的质量同样重要,甚至在某些情况下,可能比数据量和计算资源更为关键。

正确理解Scaling Law

黄仁勋强调,正确理解Scaling Law需要综合考虑多个因素。首先,数据量和计算资源的增加确实能够提升AI模型的性能,但这并不是唯一的途径。算法的优化和数据的质量同样重要。其次,数据的多样性和代表性也是影响AI模型性能的重要因素。只有综合考虑这些因素,才能真正实现AI技术的突破。

英伟达的AI前景

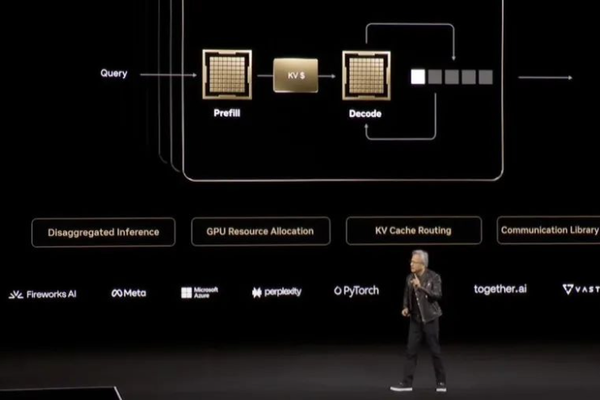

AI芯片领域的最新进展

在最新的GTC大会上,黄仁勋分享了英伟达在AI芯片领域的最新进展。公司推出了一项名为Blackwell Ultra的新一代架构,预示着性能将有望翻倍。这一进展不仅展示了英伟达在AI芯片领域的技术实力,也为AI技术的发展提供了强有力的支撑。

算力的提升

算力的提升是实现AI技术进步的重要驱动力。英伟达在AI芯片领域的不断创新,为AI模型的训练和推理提供了强大的计算支持。随着技术的不断进步,AI模型的性能将会进一步提升,应用范围也将更加广泛。

测试时计算和推理过程中的数据反馈

黄仁勋指出,未来AI发展的重要驱动力之一是三大Scaling Law的共存:算力的提升、测试时计算和推理过程中的数据反馈。这一观点引发了业界对于AI发展方向的广泛讨论和关注。通过实时的数据反馈,AI模型可以不断优化和改进,从而提高其性能和准确性。

未来发展展望

三大Scaling Law的共存

黄仁勋在采访中指出,未来AI发展的重要驱动力之一是三大Scaling Law的共存:算力的提升、测试时计算和推理过程中的数据反馈。这一观点引发了业界对于AI发展方向的广泛讨论和关注。通过综合考虑这三个因素,AI技术将会实现更大的突破。

算法优化的重要性

算法的优化是实现AI技术进步的关键。黄仁勋强调,算法的创新和优化可以显著提升AI模型的性能。通过不断优化算法,AI模型可以更好地处理复杂的任务,提高其准确性和效率。

数据质量的提升

数据质量是影响AI模型性能的重要因素。黄仁勋指出,数据的多样性和代表性对AI模型的性能有着重要影响。通过提升数据的质量,AI模型可以更好地学习和推理,从而提高其性能和准确性。

演讲影响力

行业内外的瞩目

黄仁勋作为英伟达的领军人物,一直受到行业内外的瞩目。他在各种场合的演讲,如GTC大会等,都备受关注,并成为了业界的焦点。他对AI技术的前沿探索以及对未来发展的展望,为业界提供了许多有益的启示。

对AI技术的深远影响

黄仁勋的见解和观点对于AI技术的发展和应用有着深远的影响。他所提出的关于Scaling Law的看法,为业界提供了新的思考和方向,值得广泛关注和探讨。通过深入理解Scaling Law,AI技术将会实现更大的突破,应用范围也将更加广泛。

总结与展望

回顾黄仁勋的观点

黄仁勋在GTC主题演讲中提出的关于Scaling Law的观点,为AI技术的发展提供了新的思考和方向。通过综合考虑数据量、计算资源、算法优化和数据质量,AI技术将会实现更大的突破。英伟达在AI芯片领域的不断创新,为AI技术的发展提供了强有力的支撑。

未来的发展方向

未来,AI技术的发展将会更加注重综合考虑多个因素。通过不断优化算法和提升数据质量,AI模型的性能将会进一步提升,应用范围也将更加广泛。黄仁勋的见解和观点,为AI技术的发展提供了重要的指导和启示。

期待更多突破

在充满挑战和机遇的时代,黄仁勋的见解和观点无疑对于AI技术的发展和应用有着深远的影响。期待在未来,AI技术能够实现更多的突破,为人类社会带来更多的便利和进步。